昆仑芯科技副总裁孙孝思:AI大模型的突破与创新需要算力基础设施

芯见闻 发布于 2023-03-06 18:30

近日, 2023全球人工智能开发者先锋大会(GAIDC 2023)于上海成功举办。大会以“向光而行的AI 开发者”为主题,汇聚了当前科技和产业革命中的开发者先锋力量。

作为落户于上海市临港新片区的AI芯片企业,昆仑芯科技是“芯无限,闯未来——AI芯片开发者论坛”、“智领未来:大模型技术与应用论坛”的主要协办单位之一,并深度参与上述两个论坛的主题演讲,及互动体验展区,全面展现公司的综合实力优势。

“芯无限,闯未来——AI芯片开发者”论坛上,昆仑芯科技副总裁孙孝思围绕近期爆火的ChatGPT,分析其背后的算力、算法与数据三者的关系,并指出AI大模型的突破与创新需要算力基础设施。面对场景、数据驱动下AI芯片面临的挑战,昆仑芯已与智能产业的上下游企业建立良好的合作生态,向不同行业提供以AI芯片为基础的算力产品,驱动千行百业的智能化转型。

昆仑芯科技副总裁 孙孝思

本篇以下内容整理于昆仑芯科技副总裁孙孝思题为《通用AI计算处理器——让计算更智能》演讲实录。(现场直播回放可于「昆仑芯科技视频号」查看)

2022年是整个人工智能芯片行业充满挑战的一年,从业者们都感受到丝丝寒意。因为2022年不仅处于疫情的波动期中,国际形势还对整个人工智能产业带来了限制。然而进入2023年后,ChatGPT带来了一点暖意。ChatGPT可以说是迄今为止增长最快的消费应用程序,它不是一触即发的,而是基于其前三代,不断迭代产生的,直到今天的爆发。

为什么如今有更多的人关注它,很多演讲人也不断提及它?因为ChatGPT带来了质的飞跃,超越了人类平均基准线。

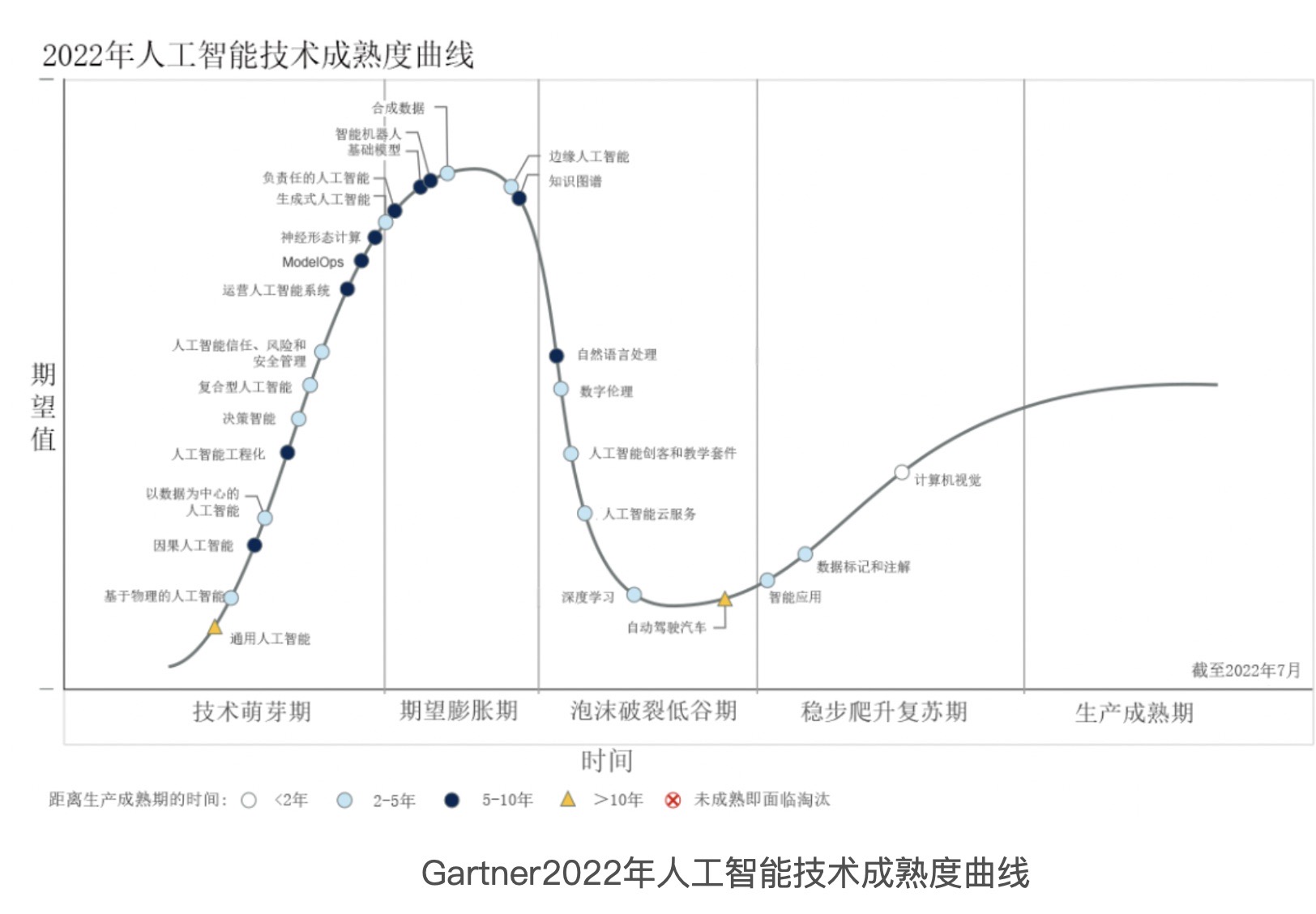

来源:Gartner2022年人工智能技术成熟度曲线

Gartner在2022年发布了一个人工智能技术成熟度曲线,生成式人工智能处于技术萌芽和期望的膨胀期,也就是说,技术从最初我们在人工智能的理解上,开始慢慢向发展阶段过渡,这对于人工智能产业中,无论是做芯片、框架,还是做算法的人来说,都是一个极大的利好。

ChatGPT背后:算法、数据、算力三要素共振

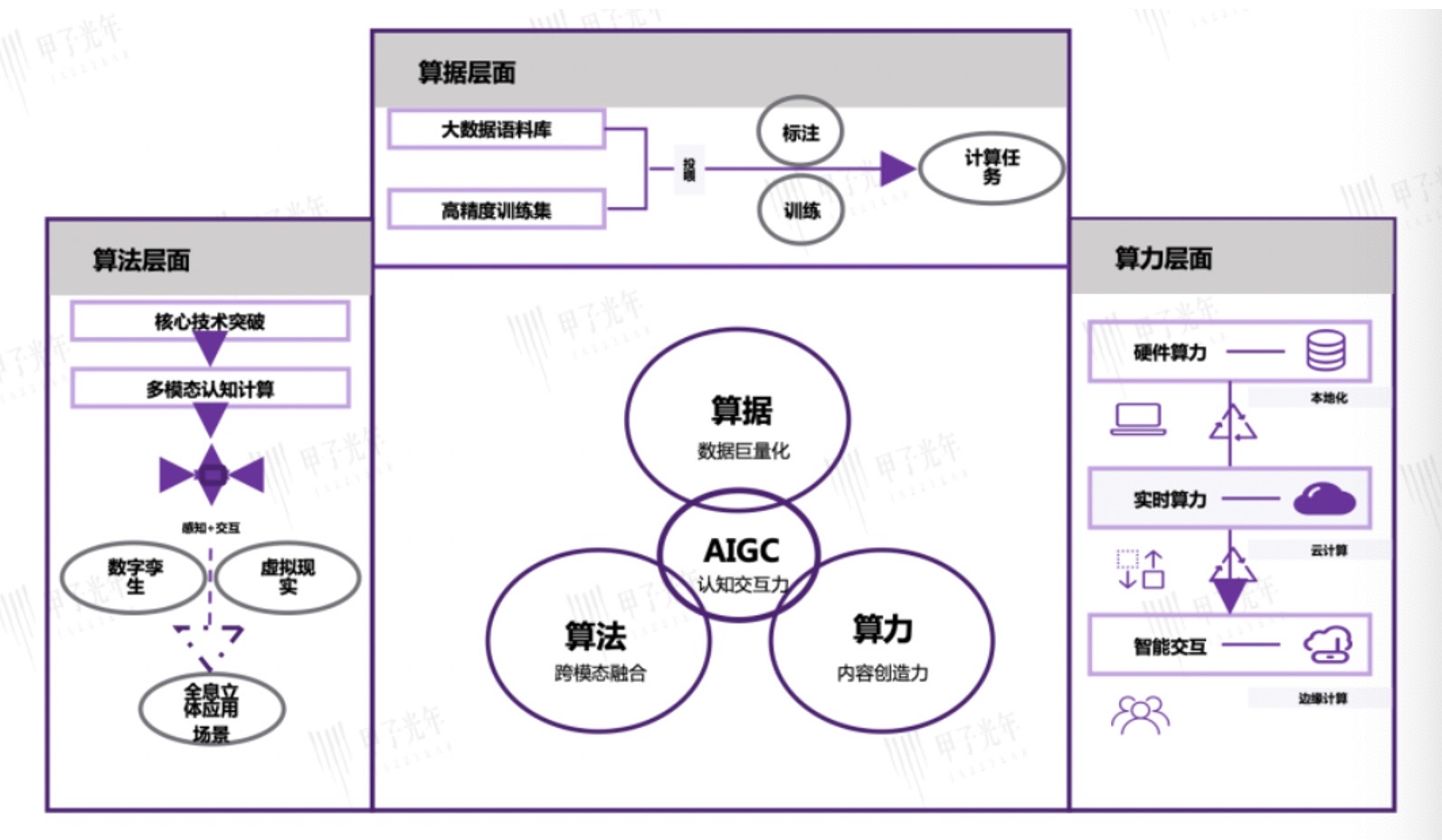

数据来源:兴业证券、甲子光年智库

ChatGPT背后是什么?今天在场的郑纬民院士以及其他很多演讲者此前都有提到,根源在于算法、数据、算力三个要素之间的共振。

算力方面,现在的ChatGPT是基于GPT3.5的大模型,在训练中使用了微软专门建设的AI计算系统,由1万个业界主流GPU组成的高性能网络集群,总算力消耗约3640 PF-days。

数据方面,GPT-2的数据量是40G,GPT3的数据量达到了45TB,这是一个大规模的数据量的跃升。

算法方面,如前所述,它不是一蹴而就的,而是经过了几次迭代。

这几年的数据、算法、算力方面都有非常大的变化。中国在数据方面非常有优势,我们有场景、有大量的数据。在算法方面,实现了跨模态的融合,包括语音、图文、视频等很多方向。算力供给方面,这几年全国各地都在推进算力建设,我们相信未来国内的应用会有很大的变化和增长。

AI大模型应用突破与技术创新:算力基础设施

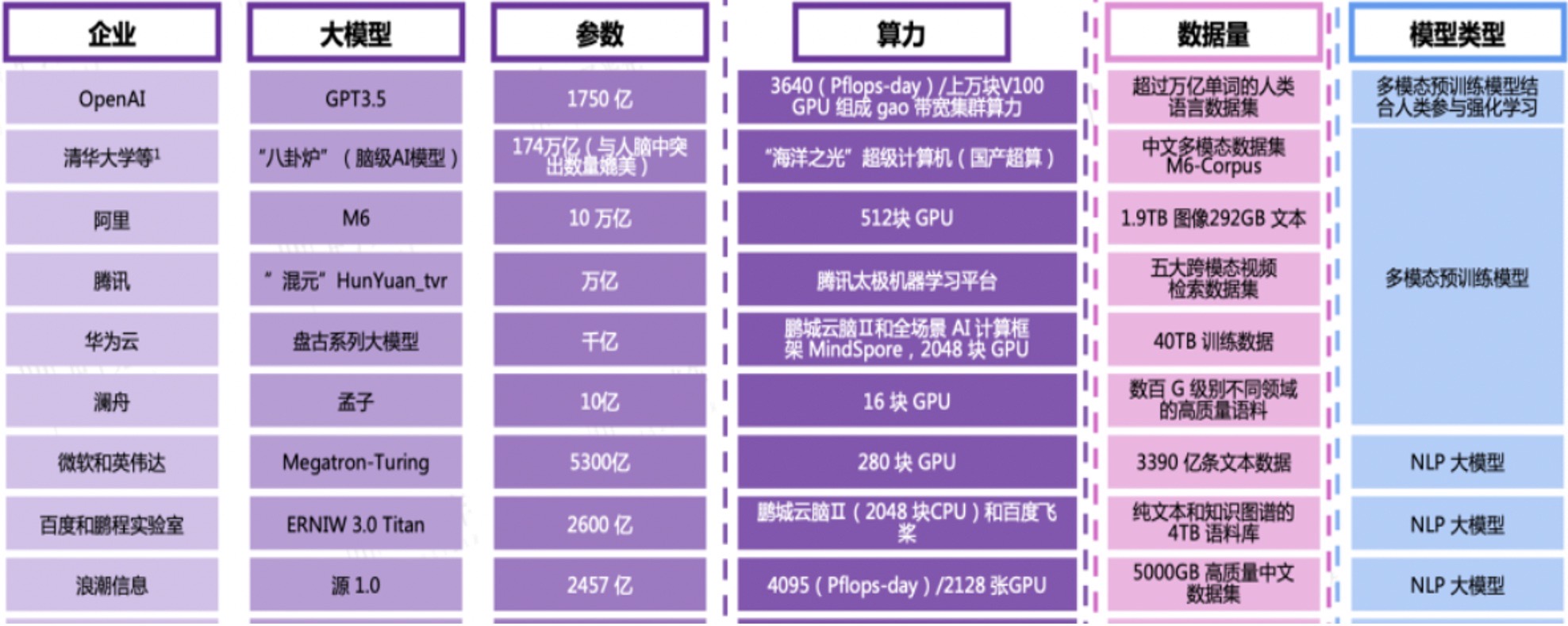

数据来源:甲子光年智库梳理

目前,国内有很多关于ChatGPT的研究,除了清华大学的“八卦炉”,还有阿里、腾讯的大模型,也包括百度。百度即将在3月16日发布的文心一言,背后其实也是大参数、大算力、大数据量。我们可以意识到,未来的应用突破和技术创新需要算力的基础设施。

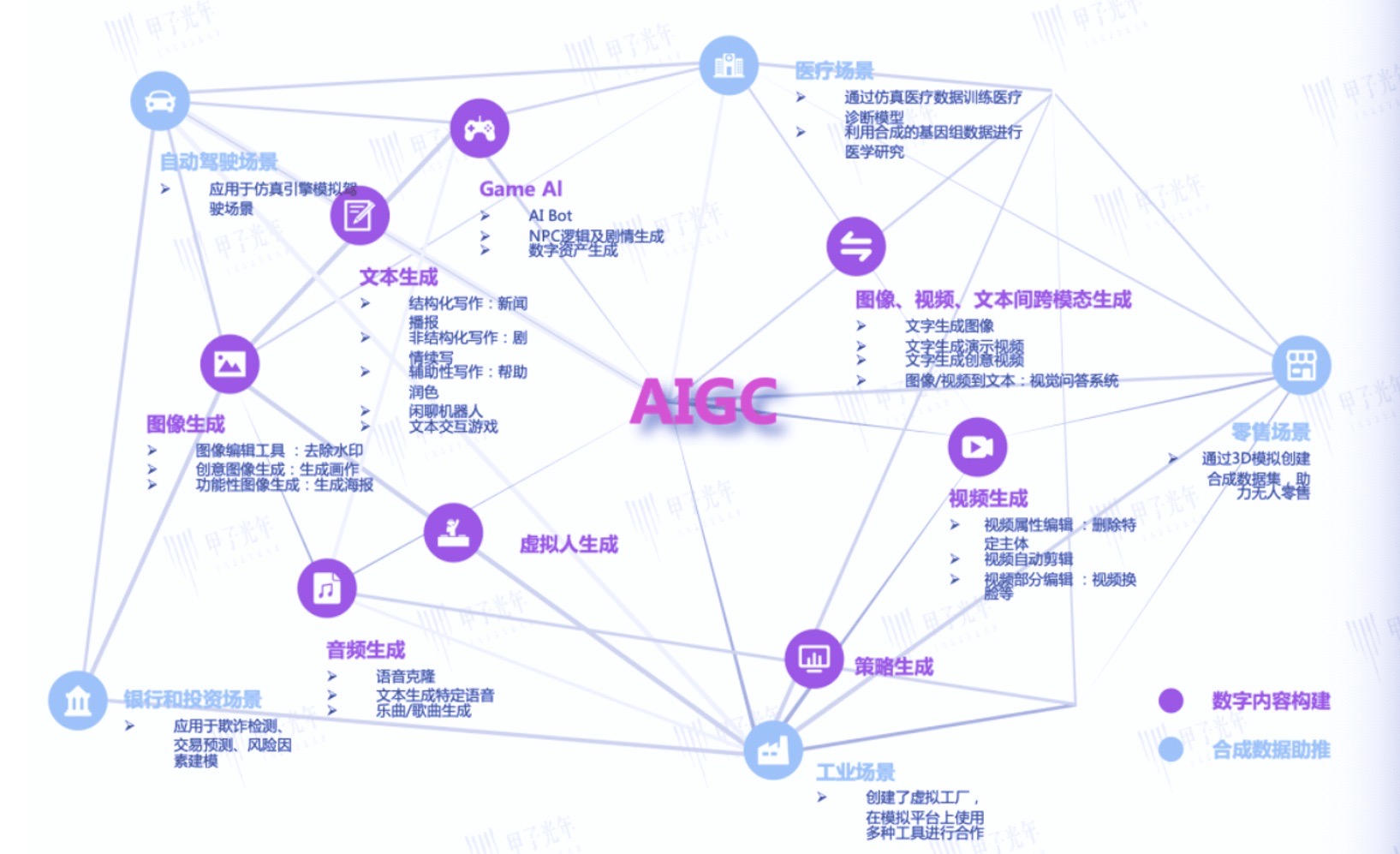

数据来源:量子位、甲子光年智库梳理

也许有人会问,下一个ChatGPT到底是什么?现在火爆的聊天、语音生成属于ChatGPT的范畴,但是未来会有很多的衍生物,例如文本生成、视频生成、音频生成、虚拟人生成方面。

我们认为,未来会有几个依托于算力的大场景,其中一大场景就是自动驾驶。自动驾驶场景中,模型感知和场景库的仿真训练需要上千P的算力。目前,我们跟新能源头部车企有很多紧密联动,我们发现自动驾驶的发展需要算力来提供技术的突破和跃升。生物医药也对算力有很强的需求,我们也看到了人工智能发挥的作用,例如AlphaFold已预测出全球几乎所有已知蛋白质结构。

可能有很多算力基础设施商都在思考,建了那么多数据中心、算力中心,到底应用在哪些地方?我们回顾一下,北京最早的京藏高速,我们叫G6,建设初期一辆车都没有,但今天却是北京堵车最严重的一条高速公路。还有4G网络,最早国家在建设4G网络的时候,大家都认为3G网络已经足够用了,为什么要上4G?为什么要投入那么大的成本?但今天看来,也有人觉得4G网络卡。所以我们要重新理解算力,它其实是信息基础设施。

算力网络的布局会很大程度激发人工智能的应用和技术创新。

目前,算力成本普遍偏高,有很多中小企业的创新在一定程度上受到了成本的影响。例如,复旦大学做MOSS大模型的时候,也会考虑到学校、科研机构是否能够承担起大模型的训练。

从政府、国家、行业的角度看,我们怎么能够实现算力的普惠?我相信2023年之后,在算力建设过程当中,除了我们这些企业,各方都将更多参与进来,这样才能够真正实现普惠,大大降低企业使用算力的成本。

场景、数据驱动下人工智能芯片的挑战

算力对于场景的创新很重要。但是作为一个人工智能芯片的企业,我们也充分认识到,在市场需求打开的情况下,整个人工智能芯片也面临巨大挑战。

资料来源:《AI算力的阿喀琉斯之踵:内存墙》

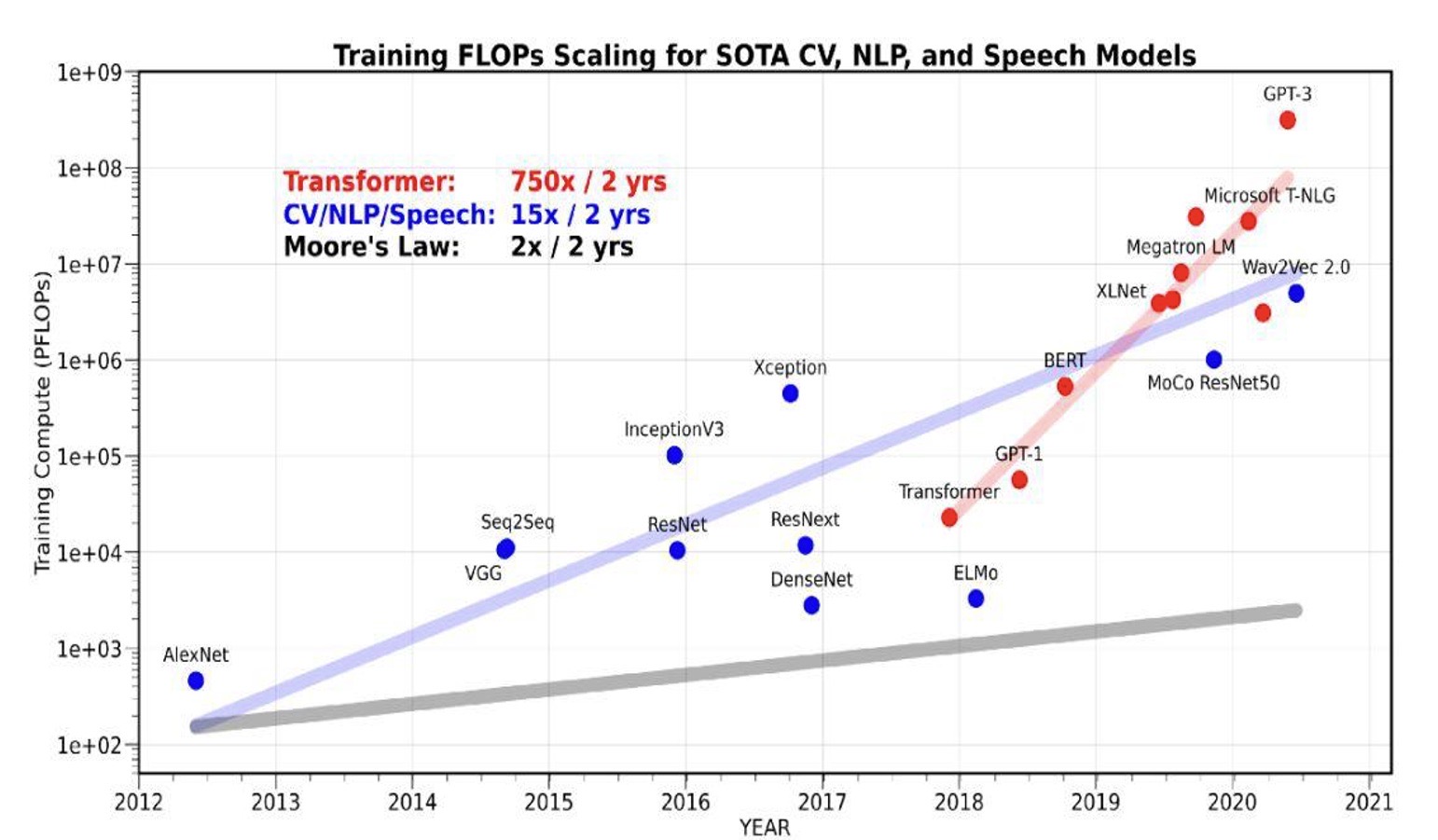

上图中,蓝线上是视频、自然语言处理和语音模型,其模型运算量平均每两年翻15倍;红线上Transformer的这种神经网络大模型,其模型运算量平均每两年会翻750倍;而灰线则标志摩尔定律下内存硬件大小的增长,平均每两年翻2倍。

因此,可以由此想到两点:第一,未来摩尔定律会面临失效的风险;第二,要考虑内存墙的存在。对于整个芯片行业的发展来说,如何在未来的演进中找到突破口,其实Chiplet是一个方向。可见,先进封装技术对于AI芯片行业将是一个重要的助推器。这几年,昆仑芯科技也在这方面做了很多基础研发。

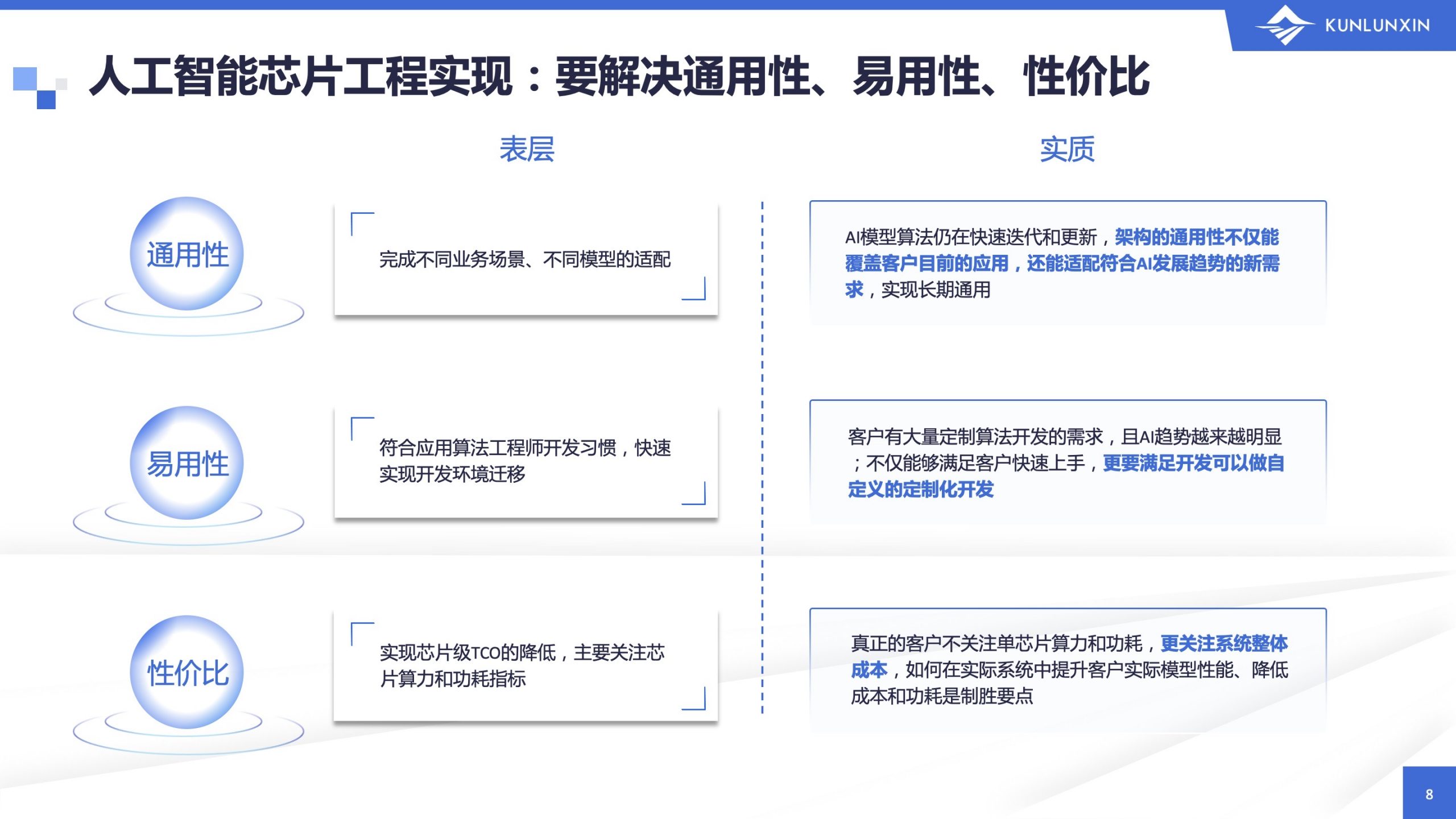

人工智能芯片离不开工程实现,为什么这么说?因为它毕竟是一个产品,想要在行业跟场景紧密结合,必须解决三个问题:通用性、易用性和性价比。

企业、高校可以在基础科研上做很多的探索,人工智能芯片企业同时必须要考虑到它的应用、商业化落地等问题。如何去解决通用性、易用性和性价比的问题,是人工智能芯片厂商共同面临的挑战。

芯片不是一个标品。在硬件层面,我们可以达到业界主流GPU产品差不多的性能指标,但在软件层面上差距较大。从同行的角度来看,我们需要自己的软件栈去解决通用性问题,也要给开发者提供更好的软件栈,让开发者可以基于国内的人工智能芯片做开发。

结语

昆仑芯科技前身是百度智能芯片及架构部,虽成立不久,却已有十余年的芯片研发经验。基于百度丰富的AI场景积累,昆仑芯产品实现了与场景需求、客户需求的紧密耦合。

基于对场景的深刻理解,昆仑芯与智能产业的上下游携手,逐步构建起软硬一体化的AI芯片生态。目前,昆仑芯产品已与百度飞桨、PyTorch、TensorFlow等主流框架和服务器完成适配。

完善解决方案才能够真正赋能产业。昆仑芯两代芯片产品均已实现量产,广泛部署在智慧金融、智慧交通、智慧工业等领域,不断提供更优秀、更高效的解决方案,为客户提供更好的服务。

未来,我们希望可以和在座的同行们一起共筑合力,赋能芯片产品与应用场景更紧密结合,在人工智能产业发展中构建更加繁荣的生态系统。

昆仑芯公众号

扫码关注昆仑芯科技公众号